学习 ChatGPT 一切基础知识的绝佳资源

OpenAI,ChatGPT,GPT系列和大型语言模型(LLM)一般 - 如果你与人工智能专业或技术专家有远程联系,你很有可能会在几乎所有的商业对话中听到这些词这些天。 炒作是真实的。我们不能再称它为泡沫了。毕竟,这一次,炒作正在兑现其承诺。 谁会想到机器可以理解和恢复类似人类的智能,并完成几乎所有以前被认为是人类强项的任务,包括音乐的创造性应用,写诗,甚至编程应用?

在线工具推荐:三维数字孪生场景工具 - GLTF/GLB在线编辑器 - Three.js AI自动纹理化开发 - YOLO 虚幻合成数据生成器 - 3D模型在线转换 - 3D模型预览图生成服务

OpenAI,ChatGPT,GPT系列和大型语言模型(LLM)一般 - 如果你与人工智能专业或技术专家有远程联系,你很有可能会在几乎所有的商业对话中听到这些词这些天。

炒作是真实的。我们不能再称它为泡沫了。毕竟,这一次,炒作正在兑现其承诺。

谁会想到机器可以理解和恢复类似人类的智能,并完成几乎所有以前被认为是人类强项的任务,包括音乐的创造性应用,写诗,甚至编程应用?

LLM在我们生活中无处不在的扩散使我们都对这项强大技术背后的内容感到好奇。

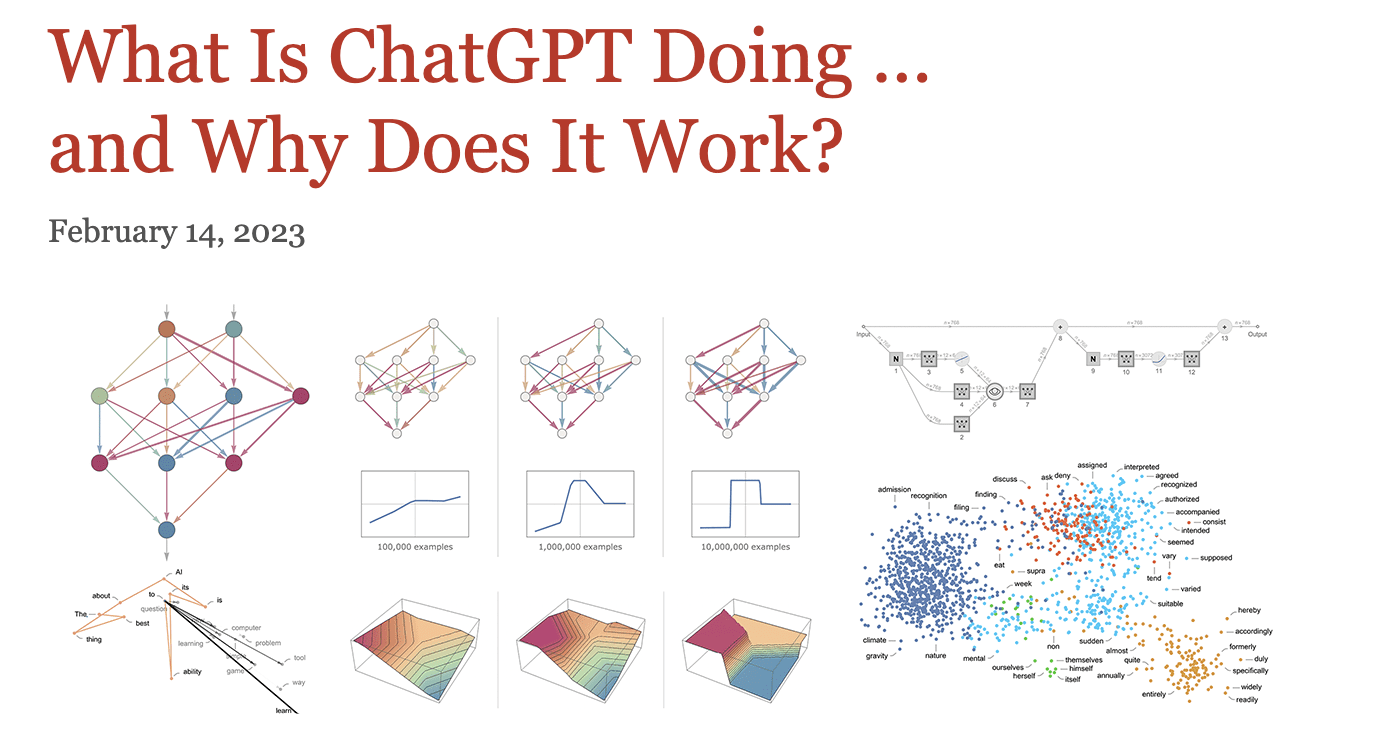

因此,如果您因为算法的血腥细节和 AI 领域的复杂性而退缩,我强烈推荐此资源来了解有关“ChatGPT 在做什么......为什么它有效?

是的,这就是沃尔夫勒姆文章的标题。

我为什么推荐这个?因为在学习变形金刚、LLM 甚至生成式 AI 之前,了解机器学习的绝对本质以及深度神经网络与人脑的关系至关重要。

它看起来像一本迷你书,本身就是文学,但请花点时间了解此资源的长度。

在本文中,我将分享如何开始阅读它以使概念更容易掌握。

理解“模型”至关重要

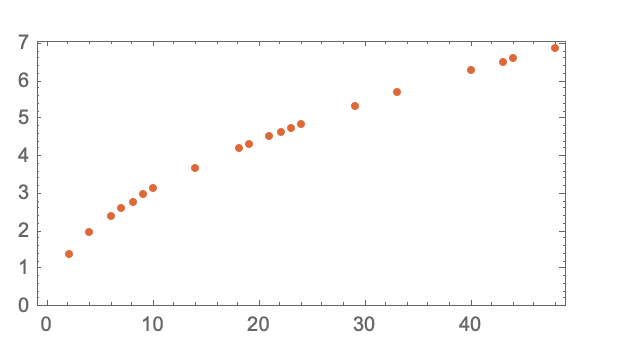

它的主要亮点是专注于“大型语言模型”的“模型”部分,通过一个球从每层楼到达地面所需的时间示例来说明。

有两种方法可以实现这一点 - 从每个楼层重复此练习或构建可以计算它的模型。

在这个例子中,存在一个基本的数学公式,可以更容易地计算,但是如何使用“模型”来估计这种现象呢?

最好的办法是拟合一条直线来估计感兴趣的变量,在本例中为时间。

对本节进行更深入的阅读会解释,永远不会有一个“无模型模型”,它可以无缝地将您带到各种深度学习概念。

深度学习的核心

您将了解到模型是一个复杂的函数,它将某些变量作为输入并产生输出,例如数字识别任务中的数字。

本文从数字识别到典型的猫与狗分类器,从猫的轮廓开始,清晰地解释了每层选择的特征。值得注意的是,神经网络的前几层会挑选图像的某些方面,比如物体的边缘。

关键术语

除了解释多层的作用外,还解释了深度学习算法的多个方面,例如:

神经网络的架构

这是艺术和科学的混合体,帖子说 - “但大多数事情都是通过反复试验发现的,添加的想法和技巧逐渐建立了关于如何使用神经网络的重要知识”。

时代

纪元是提醒模型特定示例的有效方法,以使其“记住该示例”

由于多次重复相同的示例是不够的,因此向神经网络显示示例的不同变体非常重要。

权重(参数)

您一定听说过其中一个LLM具有高达175B的参数。好吧,这显示了模型的结构如何根据旋钮的调整方式而变化。

从本质上讲,参数是“您可以转动的旋钮”以适合数据。这篇文章强调,神经网络的实际学习过程就是找到正确的权重——“最后,这一切都是为了确定哪些权重最能捕捉到已经给出的训练示例”

普遍化

神经网络学会“以合理的方式在显示的示例之间进行插值”。

这种泛化有助于通过从多个输入输出示例中学习来预测看不见的记录。

损失函数

但是我们怎么知道什么是合理的呢?它由输出值与预期值的距离来定义,预期值封装在损失函数中。

它给了我们一个“我们所拥有的价值和真实价值之间的距离”。为了减小此距离,需要迭代调整权重,但必须有一种方法可以在采用最短路径的方向上系统地减少权重。

梯度下降

在重量景观上找到最陡峭的下降路径称为梯度下降。

这一切都是为了通过导航重量环境找到最能代表基本事实的正确权重。

反向传播

继续阅读反向传播的概念,该概念采用损失函数并向后工作以逐步找到权重以最小化相关损失。

超参数

除了权重(又名参数)之外,还有一些超参数包括损失函数的不同选择、损失最小化,甚至选择“批次”示例应该有多大。

复杂问题的神经网络

神经网络在复杂问题上的使用被广泛讨论。尽管如此,这种假设背后的逻辑尚不清楚,直到这篇文章解释了高维空间中的多个权重变量如何实现可以导致最小值的各种方向。

现在,将其与更少的变量进行比较,这意味着有可能卡在局部最小值中,没有方向可以出去。

结论

通过阅读,我们已经涵盖了很多领域,从理解模型和人类大脑如何工作到将其带到神经网络、它们的设计和相关的术语。

由3D建模学习工作室 整理翻译,转载请注明出处!